ABSTRACT

自回归模型在自然语言处理中取得了显著的成功。在这项工作中,我们为机器人操纵任务设计了一个简单而有效的自回归架构。我们提出了Chunking Causal Transformer(cct),它扩展了因果关系transformers的下一个单标记预测 next-single-token prediction,以支持单次通过中的多标记预测multi-token prediction in a single pass 。此外,我们设计了一种新的注意力交织策略,使cct能够通过教师强制有效地进行训练。基于cct,我们提出了自回归policy Autoregressive Policy(arp)模型,该模型学习自回归生成动作序列。我们发现,动作序列学习能够更好地利用机器人任务中的潜在因果关系。我们在不同的机器人操作环境中评估了arp,包括push-t、aloha和rlbench,并表明它在所有测试环境中都优于state-of-the-art方法,同时在计算和参数大小方面更高效。视频演示、我们的源代码和arp模型可以在以下网址找到http://github.com/mlzxy/arp.

1 INTRODUCTION

自回归模型是自然语言处理领域最近突破的基础(min等人,2023)。这些模型基于之前的tokens预测给定序列中的下一个token。自回归模型是用因果transformers实现的,其中每个token只关注前面的模型,并且它们的训练目标是最大化每个token的条件似然。尽管它们很简单,但gpt等自回归模型(mann等人,2020)被证明具有捕捉因果依赖关系的推理能力(prystawski等人,2024)。在这项工作中,我们探索了一种简单的自回归架构的设计,该架构可用于不同环境中的各种机器人操纵任务。

Decision Transformer (DT) 和 Trajectory Transformer (TT) 是使用自回归模型解决控制任务的开创性方法(chen等人,2021;janner等人,2021)。这些方法学习生成轨迹为,其中

分别表示奖励(tamar等人,2016)、状态和时间步长t的动作。相比之下,我们建议只预测未来的动作序列,并将预测条件设定在当前状态(或观察)上。动作序列学习作为机器人应用中的一个目标更容易实现,在机器人应用中,潜在的奖励函数是未知的或定义不清的,以图像或点云形式给出的观测值是高维的,无法准确预测(kroemer等人,2021)。dt和tt主要用于完全观察低维状态变量的任务。为了应对不确定性,我们的模型在每k个时间步后生成一个新的动作序列,使用更新的新观测值并遵循模型预测控制(mpc)方法。动作序列建模还可以更好地利用机器人任务中的潜在因果依赖关系。这种因果依赖的例子包括:逻辑依赖,其中低级动作依赖于高级计划;空间依赖,其中方向取决于末端执行器的位置;以及时间依赖,其中后期动作依赖于早期动作。我们在图3中展示了真实机器人实验push-t、aloha和rlbench的动作序列设计。

我们提出了分块因果关系transformer(cct),这是一个为机器人任务量身定制的自回归模型。cct扩展了因果transformer的下一个令牌预测 next-token predictions,以支持单次通过的多令牌预测。cct从空tokens而不是从原始序列 original sequence 预测未来的tokens或一组动作 a chunk of actions,如图A1所示。在这样做的过程中,cct需要更少的推理通过 inference passes,从而更高效,并提供更强的性能,因为将动作分组为块对于需要高控制频率的机器人任务至关重要(赵等人,2023)。此外,我们设计了一种新的注意力交织策略,可以通过教师强制有效地训练cct,如图4所示。虽然赵等人(2023)之前在动作分块transformer(act)中引入了动作分块,但act是一个一步预测模型。相反,我们对自回归模型采用动作组块。我们的消融研究表明,如表1和图7所示,自回归和动作组块都是所提出模型表现强劲的关键因素。

图a1:因果关系transformer与结块因果关系Transformer。因果关系transformer在输入序列前添加“start”token[s],并用因果关系注意修改token嵌入,使最后一个token a3成为下一个token a4。分组因果关系transformer(cct)在输入序列后附加一个空的tokens块,例如e4、e5。cct通过对已知的tokens a1、a2、a3的因果注意和对空的token e4、e5的双向注意来修改token嵌入。空的tokens e4、e5成为下一个tokens a4、a5。cct可以通过拥有更多的空tokens来预测多个下一个tokens。

总之,我们的贡献有三方面。

(1) 我们提出了分块因果关系transformer(cct),它将因果关系transformer的下一个标记预测扩展到自回归模型的多标记预测。我们还设计了一种新颖的注意力交织策略,使cct能够通过教师强制进行有效的培训。

(2) 基于我们的cct,我们提出了自回归Policy(arp),这是一个学习自回归生成动作序列以解决机器人操纵任务的模型。arp架构如图1所示。

(3) 我们评估了push-t(chi et al.,2023)、aloha(赵et al.,2021)和rlbench(james et al.,2020)这三种具有不同操作任务的环境中的arp,如图2所示。我们的研究表明,arp优于所有特定于环境的sota,同时计算效率更高,使用更小的参数大小,如图5所示。此外,我们使用真实的机器人在具有挑战性的、接触丰富的螺母拧紧任务中评估arp,如图8所示。

2 RELATED WORK

Learning robotic manipulation from demonstrations.

模仿学习使机器人能够学习执行专家演示的任务(zare等人,2024)。最近,已经开发了各种方法用于具有不同任务约束和控制模式的操纵学习。值得注意的是,chi等人(2023)提出了求解push-t任务的扩散policy(dp)方法。赵等人(2023)提出了用于aloha环境中的双手动操作任务的action chunking transformer(act)。goyal等人(2024)提出了用于rlbench环境中语言条件任务的rvt-2(james等人,2020)。我们分别在图2和图6中概述了这些环境和相应的state-of-the-art(sota)解决方案。相比之下,我们提出的自回归policy是一种通用架构,在push-t、aloha和rlbench上优于每种特定环境的sota。

Sequence models for control tasks.

除了decision transformer(dt)和trajectory transformer(tt)之外,openvla(kim等人,2024)和manipllm(li等人,2024)等最新研究也研究了微调大型语言模型(llm),如llama(li等人),以将目标末端执行器姿势直接包含在基于文本的响应中。尽管这些方法取得了令人印象深刻的结果,但它们仅限于依赖于末端执行器航路点的低频控制任务(kim等人,2024)。此外,对资源密集型llm的依赖会导致巨大的计算开销,即使对于可以用轻量级模型解决的任务也是如此。如果没有这些约束,我们的自回归policy在多种环境中表现优于sota,同时在mac(乘法累加操作的数量)和参数大小方面更有效。

Hierarchical policies.

在多个抽象层次上规划行动是一种重要的能力(pateria等人,2021)。现有方法通常将低级和高级policies的设计分开,并为不同的抽象级别使用不同的模块(le等人,2018;pateria等人,2021;belkhale等人,2023;2024;chen等人,2024b)。这种复杂的程序阻碍了更广泛的应用。相比之下,我们的自回归policy通过使用单个模型预测了不同抽象级别的一系列动作。

3 METHOD

在本节中,我们介绍了自回归Policy(arp),它使用分块因果transformer(cct)来预测行为。图1总结了该架构。

图1:自回归policy架构。一系列过去的动作和一块空的tokens被连接起来并投影到嵌入中。空的tokens对应于未来的行动,这些行动是未知的,需要预测。这些嵌入与当前观测的视觉特征一起被输入到我们的分块因果关系transformer(cct)中。cct在输入嵌入中的自我关注和与视觉特征的交叉关注之间交替。自我注意是已知输入动作的因果关系,在空tokens之间是双向的。未来动作的分布是从空tokens的更新嵌入中解码出来的。

Action sequence design.

与自然语言不同,机器人动作缺乏通用词汇universal vocabulary。如图2所示,不同的机器人任务可能需要截然不同的动作类型。因此,我们建议将动作表示为结构化序列,遵循为每个任务系列预定义的格式。图3展示了在我们的真实机器人实验中生成的动作序列的格式,Push-T、ALOHA和RLBench任务。

图2:模拟环境概述。我们在Push-T、ALOHA和RLBench上评估了我们的技术,这三个任务套件具有明显不同的属性和要求。Push-T(Chi等人,2023)是一项需要许多步骤才能完成的任务(长期),并且可以通过各种方式(多模态)实现相同的子目标。ALOHA(赵等人,2023)具有高维度的动作空间(两个机械臂的14个关节)、高控制频率(50Hz)和短时间限制(8秒)。RLBench(James等人,2020)只将抓握姿势作为动作,但包含18个不同的语言条件任务。

Action embedding and decoding.

语言模型将每个单词映射到一个称为单词嵌入的连续向量上。输入句子的单词嵌入被输入到因果transformer中。下一个单词的分布是通过线性层从最后一个单词输出嵌入中解码出来的。图A2和A3说明了我们对机器人动作的嵌入和解码方法。离散动作通过在权重矩阵上查找表来嵌入,并解码为具有线性层的分类分布,类似于语言建模中的单词。连续动作嵌入一个线性层,并解码为具有另一线性层的高斯混合分布的参数。通过在视觉特征图上的坐标处检索逐点特征来嵌入定义为像素坐标的动作。输出空间分布是通过将输出嵌入与视觉特征图相乘,并使用RAFT的上采样算子将结果转换为二维热图来获得的(Teed&Deng,2020)。

图A2:离散、连续和像素坐标动作的嵌入。离散动作通过在权重矩阵上进行简单的表查找来嵌入。连续动作嵌入线性层。通过在视觉特征图上的坐标处检索逐点特征来嵌入像素坐标动作。

图A3:离散、连续和像素坐标动作的解码器。对于离散动作,我们将动作嵌入解码为具有线性层和softmax操作的分类分布。对于连续动作,我们将嵌入解码为具有线性层的高斯混合分布的参数。对于像素坐标动作,我们将嵌入与视觉特征图或权重张量相乘,并将结果转换为二维热图

Chunking causal transformer.

图a1说明了因果transformer和cct之间的本质区别。因果关系transformer用因果注意修改token嵌入,使最后一个token成为下一个token。我们的cct修改了token嵌入,对已知的tokens (过去的行为)使用因果注意,对空的token

(未来的行为)则使用双向注意。空的tokens将成为下一个tokens。这允许通过添加空tokens在单个前向传递中同时预测多个下一个tokens。优点有两个:

(1)实现了更好的准确性,因为当动作被分组成块并作为一个单元执行时,错误积累会减少(赵等人,2023)。

(2) 通过更少的前向passes可以实现更好的效率,因为每次前向pass都会同时预测多个tokens。我们在第4节中详细研究了动作组块的影响。在arp中,cct在输入嵌入中的自我关注和与视觉特征的交叉关注之间交替,如图1所示。我们从与sota方法中使用的标准骨干中提取视觉特征,详见第4节。

Train-time attention interleaving. 训练时间注意交错

在训练期间,通过将所有先前的真实 tokens 作为输入,教授因果 transformer 来预测给定序列中的每个 token。这种训练策略被命名为教师强制 teacher-forcing(williams & zipser,1989)。如图4所示,训练样本如a1、a2、a3→a4(从a1、a2和a3预测a4)、a1、a2→a3和a1→a2只需要一次前向传递。因此,因果关系transformers可以通过教师强制进行有效训练。我们遵循这种教师强制策略。然而,训练cct每chunk产生单独的前向传递。例如,a4的预测取决于a2、a3,如a1、a2、a3、e4→a4,但a2、a3需要替换为e2、e3才能从a1预测,如a1,e2,e3→a2、a3。这禁止对a1、a2、a3、e4→a4和a1、e2、e3→a2、a3使用单个前向传球。表示第i个动作,ei表示第i次动作的空token。这个问题增加了培训成本,并使training过程变得非常复杂。

为了解决这个问题,我们首先将注意力分为三类:(1)已知tokens内的因果注意力,(2)空tokens内的双向注意力,以及(3)空和已知tokens之间的因果注意力。图a4显示,已知tokens内的因果注意力是重复计算的。我们通过预先计算所有已知tokens的因果关系并缓存结果来避免这种冗余。对于空的tokens,我们结合了它们的内部双向注意力和对缓存的已知tokens的因果注意力。这使得所有tokens在三次注意力操作中都可以进行一次前向传递,而不管tokens的数量是多少。我们将此过程命名为注意力交织。图a4显示了注意力交织训练的mac减少。我们将注意力交织作为rp4880s层的内部加速机制来实现,该机制对其他网络模块是透明的。请注意,注意力交织仅在训练期间使用,不会产生额外的推理成本。

图4:在教师强制下训练块状因果关系transformer(cct)。因果关系transformers只需对给定序列中的所有tokens进行一次前向传递即可有效训练。然而,假设a2、a3和a4位于单独的块中,则预测a2、a3、a4的cct前向传递不能直接合并。如图a4所示,简单地运行单独的通道会显著增加计算成本。通过提出的注意力交织,我们预先计算并缓存了所有已知tokens a1、a2、a3的因果注意力结果。对于空的tokens e2、e3、e4,我们结合了它们的双向注意力(浅灰色)和对已知tokens(绿色、蓝色)的因果注意力。由于与已知tokens相关的所有计算都被缓存,因此我们可以在一次传递中更新所有空的tokens,而不管tokens的数量是多少。补充资料中的video/attention interleaving to ur.mp4提供了注意力交织的示例。

图a4:Naive训练与注意力交织训练。左图显示,当输入为a1、a2、e3、e4和a1、a2,a3、a4、e5、e6时,a1、a2内的因果注意力被计算了两次。通过预先计算所有已知tokens的因果注意力并缓存结果,可以减少这种冗余。这样做,mac从减少到

,其中n、k是块数和块大小。为简单起见,我们将mac计数为关注条目的数量。除了mac减少外,我们发现对所有tokens进行一次前向传球可以产生更清晰的训练过程,这一好处无法通过乘法累加操作的原始数量来量化。

Inference.

在测试推出期间,我们从当前观察中提取视觉tokens,并将其作为arp的输入,arp然后通过从解码的动作分布中采样并将所选动作附加到现有动作序列中,自动回归地生成动作。重复生成和执行操作的过程,直到事件终止(成功、失败或达到时间限制)。根据图3所示的序列格式生成操作,每个任务具有预定义的块大小和目标长度。我们在第4节和附录a.2中提供了额外的实现细节和超参数值。

4 EXPERIMENTS

在本节中,我们将研究自回归policy(arp)与专门为每种环境设计的现有方法相比的性能。此外,我们还研究了自回归和动作组块是否是性能提升的主要因素,并评估了现有方法在不同环境中的表现。此外,我们使用真实的机器人在具有挑战性的螺母拧紧任务中验证了arp。最后,我们证明arp可以估计机器人动作的可能性,并根据人类输入预测动作。我们所有的源代码和预训练模型都可以在http://github.com/mlzxy/arp。我们的自回归policy的单文件实现可以在arp.py中找到。

4.1 COMPARISON WITH STATE-OF-THE-ART

Setup.

我们将自回归policy(arp)与push-t、aloha和rlbench环境中的sota解决方案进行了比较。push-t是一个单一的任务。aloha由两个任务组成:插入和立方体传输。rlbench包括18个任务,每个任务都有多种语言变体。这些环境如图2和图a5所示。对于push-t和aloha,我们为每个任务训练一个单独的policy。对于rlbench,一个policy被训练用于所有18个任务。在push-t中,policy观察最后两个96×96 rgb帧,并预测未来二维指针位置的窗口作为动作。在aloha中,policy观察当前的480×640 rgb帧,并预测未来14维关节位置的窗口。在rlbench中,policy观察了四张rgbd 128×128图像,并预测了下一个目标末端执行器的姿态和夹持器状态。图6概述了这些环境中现有的sota技术。我们使用与sota解决方案相同的视觉骨干来提取视觉tokens,即push-t和aloha的resnet50(he等人,2016)和rlbench的多视图transformer(goyal等人,2023)。我们使用与sota解决方案相同的训练数据、发作次数、优化器配置和评估频率。我们在附录a.2中详细介绍了超参数的完整列表,如层数、序列长度、块大小和优化器设置。push-t和rlbench的成功率是三次独立运行的平均值。aloha的结果是五次运行的平均值。

Results.

图5显示,我们的自回归policy(arp)优于特定环境的sota,同时计算效率更高。表a4比较了arp和rvt-2的每项任务成功率(goyal等人,2024)。此外,我们报告了arp+的结果,它与arp共享相同的网络定义,但具有更多的层。rvt-2、arp、arp+的mac/参数大小分别为72.1m/57.1g、71.9m/56.2g和73.8m/57.4g。值得注意的是,arp+的平均成功率为86%,计算成本略有增加。请注意,rvt-2的成功率最初报告为81.6%。但这是通过使用逻辑时间步长 logical time-step作为额外输入来实现的,该时间步长表示任务进度(子任务里程碑)。许多现有作品都遵循了这一惯例(shridhar等人,2023;goyal等人,2023)。然而,在实际应用中,这些信息是不可用的。因此,我们在没有输入时间步长的情况下训练所有rlbench模型。

4.2 ANALYSIS

性能提升是否来自自回归?

我们的动作序列设计结合了Push-T和ALOHA的额外输入,如图3所示。这些输入是从演示轨迹中自动提取的。在Push-T中,高级航路点只是从低级轨迹中均匀采样,然后离散化。在ALOHA中,末端执行器的像素坐标是根据机器人的前向运动学和相机参数的关节值计算的。ARP的性能提升可能源于这些额外的信息,而不是我们提出的自回归架构。

表1:自回归与一步预测和sota。基线是指sota(push-t的扩散Policy和aloha的act)。自回归是我们提出的方法,其中动作是自回归生成的。一步预测与所提出的方法共享相同的实现和训练数据,但在单个步骤中生成整个动作序列。

表1比较了push-t和aloha中自回归和一步预测的成功率。两者共享相同的实现,通过将cct块大小设置为完整序列长度,一步预测一次生成整个序列。基线是指push-t的Diffusion Policy和aloha的act。结果清楚地表明,自回归是实现更好性能的关键因素。我们的直觉可以通过一个例子来解释:想象任务B很难,但先解决任务A,然后再解决任务(任务b给定任务a的结果),要容易得多。自回归模型遵循这个顺序过程,首先解决任务a,然后利用结果使任务b更可行。相比之下,一步模型试图同时预测这两个任务,将a和b视为独立的问题。虽然一步模型可以隐式地解决任务a,作为解决任务b的一部分,但它没有明确利用问题结构,因此容易走捷径。prystawski等人(2024)在nlp任务中对这一现象进行了更深入的探索。

Do existing methods work in different environments?

表2显示了现有方法在不同环境中的表现。在新环境中进行测试时,我们保持相同的架构,但使视觉骨干和优化器适应环境的既定设置。rvt-2没有用于push-t和aloha,因为它是为稀疏航路点预测而设计的,这与这些任务中所需的高频动作不兼容。我们没有为rlbench实现Diffusion Policy,因为它从高斯噪声中提炼出动作,这与rlbench在离散空间中预测动作的常见做法相冲突。虽然3d扩散器actor(ke等人,2024)报告了rlbench的竞争结果,但它使用了完全不同的架构。

表2:各种环境下现有方法的评估。act是一种基于vae的方法,在所有环境中都具有竞争力,而diffusion Policy在aloha和rlbench中表现不佳。虽然我们相信未来可以开发出更强大的基于扩散的架构,但我们的结果表明,更简单的架构在各种任务中往往更稳健。

表A4:RLBench上的性能。我们报告每个任务的成功率,并衡量所有任务的平均成功率和排名。ARP+与ARP共享相同的网络定义,但具有更多的层。RVT-2、ARP、ARP+的MAC/参数大小分别为72.1M/57.1G、71.9M/56.2G和73.8M/57.4G。ARP在所有任务上的性能相当或优于RVT-2。值得注意的是,ARP+在具有挑战性的栓钉插入任务中取得了97.3%的成功率。

表2显示,基于vae的act方法在所有环境中都具有竞争力,而diffusion policy在aloha中难以提供有意义的性能。考虑到最近基于扩散的技术的流行,这一结果令人惊讶。虽然我们相信可以为aloha开发一种强大的扩散架构,如rlbench上的3d扩散器actor,但这表明更简单的架构在更广泛的任务和环境中可能更稳健。我们的自回归policy训练有一个目标:最大化序列中每个动作的条件似然。我们认为,这种简单性有助于其在各种环境中保持稳健的性能。

Does action chunking improve performance?

我们的组块因果关系transformer(cct)能够预测多个下一个tokens,即一组动作,而不是只预测下一个token。图7说明了块大小和成功率之间的关系。第一幅图显示,较大的区块显著提高了policy的性能,act也观察到了这一趋势(赵等人,2023)。组块动作的这一优势似乎可以推广到短期任务中的高频控制。有趣的是,虽然关节位置的较大块大小可以提高性能,但如表1所示,同时预测末端执行器航路点和关节位置的单次预测结果较差。

图7:块大小对性能的影响。我们的结果表明,最佳块大小取决于任务和动作序列设计。因此,我们的组块因果transformer灵活调整组块大小的能力对于最大限度地提高性能至关重要。

图a6:push-t的展平动作序列。基于图3中的动作序列,我们删除了高级航路点,并将2d坐标展平为单个向量。例如,将(x1,y1)、(x2,y2)、(x3,y3)的轨迹变换为向量(x1,y1,x2,y2,x3,y1)。policy被训练为首先预测初始点的x坐标,然后预测y坐标,然后是后续点的x和y坐标。

第二个图表明,对于push-t,policy性能对低级轨迹的块大小基本不敏感,因为成功率的标准偏差在1到2之间。在这种情况下,考虑到只执行前几个预测动作然后重新运行policy的常见做法,中等块大小可能是更好的选择,测试时间技术可以减少错误累积。该技术通过提前终止自回归生成而受益于适度的块大小,而不会牺牲性能或计算效率。

在第三个图中,我们探索了push-t的不同动作序列格式,其中我们删除了高级航路点,并将轨迹展平成矢量,如图a6所示。这种设计产生了一种完全不同的趋势,只有当块大小为1时,policy才能表现良好。第四幅图显示,增加高级航路点的块大小可以提高policy的性能。这些发现表明,最佳块大小取决于任务和动作序列格式。因此,cct灵活调整块大小的能力对于最大限度地提高性能至关重要。目前,每个任务的块大小都是手动指定的,但如第5节所述,自适应调整块大小的更有原则的方法将是理想的。

4.3 REAL ROBOT EXPERIMENT

Setup

我们使用真实的机器人在具有挑战性的拧紧螺母任务中评估arp,这需要螺母和扳手之间精确对齐,公差为2mm,如图8所示。

图8:真实的机器人实验。我们的ARP学会自适应地选择高级命令并生成低级动作值,包括插入失败后的位置调整。通过这样做,我们在需要精确工具对齐的螺母拧紧任务中实现了8/10的成功率。螺栓的位置(蓝色)和螺母的高度(黄色)在每次发作时都是随机的

在每一集中,螺栓(蓝色)被随机放置在20×20平方厘米的桌子上,而螺母(黄色)的高度沿着6厘米高的螺栓随机排列。螺栓和螺母的方向也按事件随机分配。我们定义了三个基本动作:伸展、调整和闩锁。在每一步中,我们的arp都会预测一个高级命令来选择操作,然后生成相应的低级操作值。例如,arp首先预测到达命令和插入姿势。接下来,机器人试图插入扳手。每次尝试失败后,policy都会预测调整方向,以调整扳手的位置并重新尝试插入。一旦插入成功,policy将切换到螺钉命令,并预测将遵循的密集轨迹,以便围绕扳手旋转末端执行器。所有命令都由自主模型自动预测,而不是手动指定。阻抗控制器基于力反馈停止不成功的插入。我们在kuka lbr iiwa机器人上部署了这个模型。我们使用单个realsense d415相机的480×640 rbg-d观测结果。我们使用MVT作为视觉支柱。为了简化任务,我们假设扳手已经被机器人在预定义的位置抓取。如果在不超过三次尝试将扳手对准螺母后完成螺钉操作,则认为该事件是成功的。我们使用从专家policy收集的70个演示来训练arp。专家policy使用foundation pose(m ornek等人,2023)来估计插入姿势,由人类操作员提供精细的调整。

Results

图8显示,arp在10次事件中有8次成功拧紧螺母,而专家policy在没有人为干预的情况下只有3次成功。大多数剧集在没有任何调整的情况下都成功了,因为我们在训练中使用了调整后的成功插入姿势作为伸展命令的标签。为了测试arp的自适应调整能力,我们在插入姿势的法线平面上添加了一个范围在-5mm和5mm之间的均匀噪声。尽管存在额外的噪音,我们的arp在10次试验中仍有6次成功,每次试验的平均调整次数为1.6次。

4.4 QUALITATIVE VISUALIZATION

我们在图A5中展示了所有评估任务。ARP在模拟和现实世界中的视频演示可在补充材料中的Video/demo.mp4文件中找到。在本节中,我们将展示ARP的两个关键优势:(1)估计给定机器人动作的可能性,(2)预测基于人类输入的动作

Likelihood inference.

为了生成下一个token ,一个自回归模型估计条件概率

。使用乘积规则,该模型可以估计任何给定序列的联合概率

,这是vae和扩散等更先进的生成框架所缺乏的能力。图9显示了arp估计的不同轨迹的可能性。所有这些轨迹都是人类的展示。arp通常为有效轨迹分配更高的可能性,为无效轨迹分配较低的可能性。例如,在子图(b)中,arp为t对象周围的两个对称轨迹分配了高似然性,展示了其对动作多模态的理解。然而,一些可能性分配不太直观。例如,轨迹、和的可能性适中,但它们可能不会使t形物体更接近绿色目标,至少不会比低可能性轨迹和2更好。标记了两个相似的轨迹,但它们的可能性不同。我们认为,这种可能性推理可以帮助识别模型的弱点,并从训练数据中消除有缺陷的演示。

图9:轨迹似然估计。ARP通常为有效轨迹分配比无效轨迹更高的可能性,并如子图(b)所示,展示了其对动作多模态的理解。ARP的似然推理能力可以帮助识别模型弱点并发现有缺陷的演示。所有轨迹都是人类绘制的,不是训练集的一部分。

Prediction with human guidance.

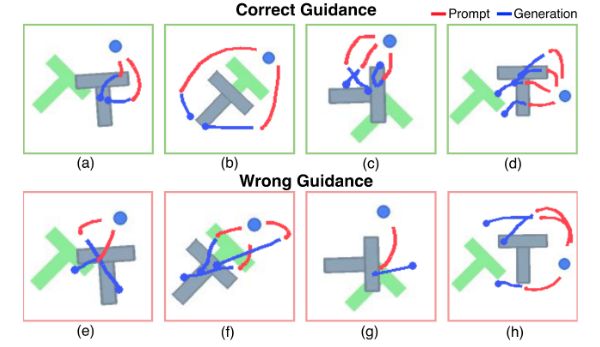

自回归模型生成以先前序列为条件的未来tokens。在图10中,我们展示了pusht中arp(蓝色)的轨迹示例,这些轨迹是根据人类绘制的初始轨迹(红色)有条件预测的。第一行(绿色)显示了在正确指导下的预测,其目的是成功完成任务。第二行(粉红色)基于错误的指导,意图使任务失败。arp在给定正确的初始部分的情况下正确地完成了轨迹。如果启动错误,子图(g)显示了arp通过纠正其初始轨迹从故障中恢复。然而,在子图(e)和(f)中,arp通过进一步向错误的方向推进来放大初始误差。这种行为可能反映了arp的分布外响应,因为训练集只包含成功的演示。

图10:基于人类引导的轨迹预测。我们展示了ARP的预测轨迹(蓝色),以人类绘制的轨迹(红色)为条件。正确的指导是为了完成任务,而错误的指导则是为了失败。ARP在正确的指导下按预期运行。在错误的指导下,ARP从子图(g)中的失败中恢复,避免子图(h)中的进一步错误,并放大子图(e)和(f)中的错误,这反映了分布外的行为,因为训练集只包含成功的演示。

5 DISCUSSION

我们已经证明,ARP是一种强大而通用的架构,可以训练来执行各种操作任务。接下来,我们将讨论它的局限性和潜在的未来方向。

Learning to plan.

规划是智能agents的关键能力。它要求agent不仅要对其行为进行推理,还要对其对环境的影响进行推理(garrett等人,2021)。受nlp中自回归模型推理能力的启发,一个有前景的方向是将规划纳入arp。一种可能的解决方案是预测状态和动作的顺序。机器人技术中的状态通常是高维的,如图像或点云。因此,最好只预测关键状态,而不是在未来生成每一帧。为了解决这个问题,arp可以通过使用最近的自回归和扩散的混合架构来扩展以生成未来状态,例如扩散强迫 Diffusion Forcing(chen等人,2024a),

Interactive robot learning.

人机协作通过允许机器人从错误中恢复来提高效率(Mukherjee等人,2022;Liu等人,2023)。一个可能的未来方向是将主动学习技术集成到ARP中,从即时的人类反馈中学习。自回归机制自然支持对人类输入的条件作用预测。此外,ARP可以估计动作序列的可能性。可能性是识别主动学习中信息量最大的样本的常用指标(Taylor等人,2021)。例如,这可用于优先演示机器人遇到更多困难的任务。

Adaptive action sequence learning.

尽管ARP的性能令人印象深刻,但它仍然需要为每个环境手动设计动作序列格式和块大小。开发一种自动确定最佳块大小的通用方法不仅可以提高ARP的性能,还可以加深我们对机器人模仿学习中动作块技术的理解。我们在附录A.3中讨论了动作组块何时以及为什么重要。此外,与自然语言不同,机器人动作缺乏通用词汇。一个有前景的方向是设计一种适用于多种环境的通用机器人动作语言,这将降低定义新动作的成本,统一训练数据集,并提高泛化能力。

本站资源均来自互联网,仅供研究学习,禁止违法使用和商用,产生法律纠纷本站概不负责!如果侵犯了您的权益请与我们联系!

转载请注明出处: 免费源码网-免费的源码资源网站 » 【论文阅读】AUTOREGRESSIVE ACTION SEQUENCE LEARNING FOR ROBOTIC MANIPULATION

发表评论 取消回复