文章目录

MapReduce概述

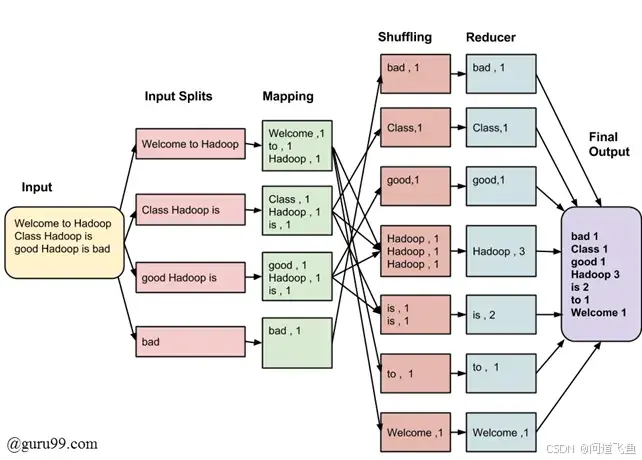

MapReduce是一个分布式计算框架,它允许用户编写可以在大规模集群上并行处理大数据集的应用程序。MapReduce模型由两个主要的函数组成:Map和Reduce,它们分别对应数据处理的两个阶段。以下是MapReduce的详细说明:

1. MapReduce编程模型

Map阶段

- 输入:Map阶段的输入通常是一组键值对(key-value pairs)。

- 处理:用户编写的Map函数对输入数据进行处理。Map函数读取输入的键值对,执行业务逻辑,然后输出中间键值对。

- 输出:Map函数的输出是一组中间键值对,这些输出将作为Reduce函数的输入。

Reduce阶段

- 输入:Reduce阶段的输入是Map阶段输出的所有中间键值对。

- 处理:用户编写的Reduce函数对具有相同键的所有中间值进行处理。Reduce函数接收一个键和一组值,执行业务逻辑,然后输出最终结果。

- 输出:Reduce函数的输出是一组最终的键值对,这些结果通常被写入到分布式文件系统(如HDFS)中。

2. Shuffle和Sort阶段

在Map和Reduce阶段之间,MapReduce框架自动执行Shuffle和Sort操作,这个过程对用户是透明的。

- Shuffle:这个过程涉及将Map输出的数据传输到Reduce任务。Shuffle确保每个Reduce任务接收到所有属于其处理的键值对。

- Sort:在数据传输给Reduce任务之前,MapReduce框架会对每个Reduce任务的数据进行排序,确保具有相同键的值被分组在一起。

3. MapReduce作业的执行流程

- 作业提交:用户提交一个MapReduce作业到集群。

- 任务调度:作业被分割成多个Map任务和Reduce任务,由集群的资源管理器进行调度。

- Map任务执行:每个Map任务处理输入数据的一个分片,生成中间键值对。

- Shuffle和Sort:Map任务的输出被Shuffle和Sort,为Reduce任务准备数据。

- Reduce任务执行:Reduce任务处理排序后的中间数据,生成最终结果。

- 输出结果:Reduce任务的输出被写入到分布式文件系统或其它存储系统中。

4. MapReduce的优化和特性

- 数据局部性:MapReduce尝试将计算移动到数据所在的位置,以减少网络传输。

- 容错性:MapReduce框架能够处理节点故障,通过重新执行失败的任务来确保作业的完成。

- 扩展性:MapReduce设计用于在成百上千的节点上运行,能够处理PB级别的数据集。

- 高吞吐量:通过并行处理和优化的数据传输,MapReduce可以实现高吞吐量的数据加工。

5. MapReduce的配置和调优

- 分区(Partitioning):用户可以通过实现自定义分区器来控制数据如何分配给不同的Reduce任务。

- 合并(Combining):在Map阶段,用户可以定义一个Combiner函数来减少网络传输的数据量。

- 资源管理:用户可以配置Map和Reduce任务的内存使用量,以及其他资源需求。

MapReduce是一个强大的工具,但它也有一些局限性,比如不适合实时数据处理,以及对于复杂的数据处理流程可能不够灵活。因此,许多新的框架和工具(如Apache Spark)被开发出来,以提供更丰富的数据处理能力。尽管如此,MapReduce仍然是大数据处理领域的一个基础概念,并且它的许多原则和模式在新的技术中得到了延续。

MapReduce局限性

MapReduce是一种编程模型和处理框架,用于在大规模集群上并行处理大数据集。尽管MapReduce在大数据处理领域有着广泛的应用,但它也存在一些局限性:

-

实时计算性能差:MapReduce主要适用于离线数据处理,不适合需要实时或近实时处理的场景。它无法像传统的数据库系统那样在毫秒或秒级别内返回结果。

-

不适合流式计算:流式计算要求数据是动态的,而MapReduce设计上是针对静态数据集的。因此,MapReduce不适合处理持续不断流入的数据。

-

高延迟:MapReduce的数据处理流程通常涉及多个阶段,包括Map、Shuffle和Reduce,这导致整个处理过程的延迟较高,不适合需要快速响应的交互式应用。

-

磁盘I/O开销大:在MapReduce中,中间结果需要写入磁盘,这可能导致大量的I/O操作,成为性能瓶颈。

-

不适合复杂计算:MapReduce框架主要提供Map和Reduce两种操作,对于复杂的计算任务,可能需要多个MapReduce作业串行运行,这增加了开发和维护的复杂性。

-

资源利用率低:MapReduce作业通常需要等待所有Map任务完成后,Reduce任务才能开始,这种模式可能导致资源利用率不高,特别是在数据倾斜或某些任务执行时间较长时。

-

内存使用不足:MapReduce主要依赖磁盘存储,而不是内存。这限制了处理速度,因为磁盘I/O远慢于内存访问。相比之下,新的框架如Spark利用内存计算,大大提高了处理速度。

-

容错机制:虽然MapReduce具有容错性,但它的处理方式可能在节点故障时导致较高的计算成本,尤其是在需要重新计算失败任务时。

-

过于底层:MapReduce提供的抽象层次较低,对于非技术人员或数据分析师来说,编写MapReduce程序可能较为困难,不如SQL等更高级的抽象易于使用。

-

不适合迭代计算:某些算法,如机器学习的模型训练,需要状态共享或参数间有依赖,MapReduce不适合这类需要迭代处理的计算任务。

由于这些局限性,MapReduce可能不适用于所有类型的数据处理任务,特别是那些需要低延迟、高吞吐量、复杂计算或实时处理的场景。因此,许多新的框架和工具,如Apache Spark,被开发出来以提供更灵活、更高效的大数据处理能力。

相关文献

本站资源均来自互联网,仅供研究学习,禁止违法使用和商用,产生法律纠纷本站概不负责!如果侵犯了您的权益请与我们联系!

转载请注明出处: 免费源码网-免费的源码资源网站 » 【分布式知识】MapReduce详细介绍

发表评论 取消回复